As indústrias de hoje em dia têm mais dados à disposição do que nunca. Mas quando se trata de seus ativos mais críticos, como as empresas devem aproveitar os dados para prever e prevenir problemas antes que eles aconteçam?

A partir do surgimento da inteligência artificial (AI) e da Internet das Coisas (IoT), empresas de todos os setores estão sendo reinventadas. As empresas estão aprendendo a usar seus dados não apenas para analisar o passado, mas também para prever o futuro.

Estamos em um ponto de virada significativo na história. O mundo industrial está sendo revolucionado. No epicentro dessa mudança, há quatro elementos principais: Artificial Intelligence (AI), Machine Learning (ML), Big Data (BD) e Internet das Coisas (IoT).

Hoje, bilhões de pessoas e inúmeras máquinas estão conectadas umas às outras. Por meio de tecnologia inovadora, velocidade e poder de processamento sem precedentes e computação distribuída em escala massiva onipresente, os dados podem ser coletados e aproveitados como um ativo comercial em magnitude imensa. Novas portas foram abertas pela conectividade, ciência de dados, automação e computação incorporada. Prever o futuro não é mais um conceito futurista – é a nossa realidade.

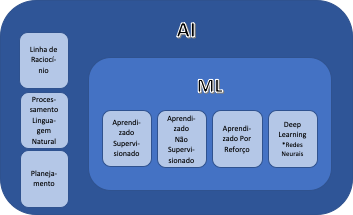

AI x ML

Artificial Intelligence (AI) e Machine Learning (ML) são frequentemente usados de forma intercambiável. Isso é um engano, porque o ML é um subconjunto importante da AI. Os avanços de hoje em AI estão sendo amplamente impulsionados pelo uso de ML para processar grandes quantidades de dados.

- AI é um termo mais amplo usado para se referir à capacidade das máquinas de executar tarefas que normalmente exigem funções cognitivas humanas. Existem várias definições para AI, algumas muito semelhantes. O English Oxford Living Dictionary define AI como “a teoria e o desenvolvimento de sistemas de computador capazes de executar tarefas que normalmente exigem inteligência humana, como percepção visual, reconhecimento de fala, tomada de decisão e tradução entre idiomas”.

- O ML é o uso da computação estatística para entender tendências, padrões, características, atributos e estrutura dos dados, para informar decisões com novas observações. É um campo da ciência da computação que oferece aos sistemas a capacidade de aprender com os dados para melhorar o desempenho de tarefas específicas, sem serem explicitamente programados para isso.

A Inteligência Artificial (AI) existe há muito tempo – na mitologia grega existem histórias de homens mecânicos projetados para imitar o comportamento humano. Os computadores europeus muito antigos foram concebidos como “máquinas lógicas” e, ao reproduzir recursos básicos como aritmética e memória, os engenheiros viram seu trabalho, fundamentalmente, como tentar criar cérebros mecânicos.

À medida que a tecnologia evoluiu e, o que é mais importante, nossa compreensão progrediu acerca de como as mentes humanas funcionam, o conceito do que constitui a AI mudou. Em vez de cálculos cada vez mais complexos, o trabalho no campo da AI concentrou-se em imitar os processos de tomada de decisão humana e a executar tarefas de maneira cada vez mais humanas.

As inteligências artificiais – dispositivos projetados para agir de maneira inteligente – são frequentemente classificadas em dois grupos fundamentais – aplicadas ou gerais. A AI aplicada é muito mais comum – sistemas projetados para negociar ações de forma inteligente ou manobrar um veículo autônomo, se enquadram nessa categoria. As AIs generalizadas – sistemas ou dispositivos que, em teoria, podem lidar com qualquer tarefa – são menos comuns, mas é aqui que alguns dos avanços mais emocionantes estão ocorrendo atualmente. É também a área que levou ao desenvolvimento do Aprendizado de Máquina (ML). Geralmente chamado de subconjunto da AI, é realmente mais precioso pensar na ML como o estado da arte atual.

Dois avanços importantes levaram ao surgimento do ML como o veículo que impulsiona o desenvolvimento da AI com a velocidade que atualmente possui. O primeiro importante avanço foi a constatação – creditada a Arthur Samuel em 1959 – de que, em vez de ensinar aos computadores tudo o que eles precisam saber sobre o mundo e como realizar tarefas, talvez seja possível ensiná-los a aprender por si mesmos.

O segundo avanço, mais recente, foi o surgimento da Internet e o enorme aumento na quantidade de informações digitais geradas, armazenadas e disponibilizadas para análise.

Quando essas inovações foram implementadas, os engenheiros perceberam que, em vez de ensinar computadores e máquinas a fazer tudo, seria muito mais eficiente programá-los para pensar como seres humanos e conectá-los à Internet para dar acesso a todas as informações disponíveis no mundo.

Como o Machine Learning funciona na indústria?

Os produtos de IoT, no caso de empresas de varejo ou entretenimento, geram dados em uma nuvem centralizada para com o objetivo de aprimorar as experiências de seus clientes. A Netflix, por exemplo, usa algoritmos de Machine Learning para recomendar conteúdo de vídeo adicional aos espectadores. De fato, 75% de todas as visualizações da Netflix são direcionadas pelo algoritmo de recomendação da empresa. Graças à computação em nuvem, a Netflix pode processar facilmente grandes quantidades de dados de todos os seus milhões de clientes. Mas e quando seus dados não estão centralizados? O que acontece quando você obtém grandes quantidades de dados, não do seu smartphone ou TV, mas de equipamentos industriais descentralizados localizados ao redor do mundo?

Nos diversos setores industriais, existem desafios únicos quando se trata de dados gerados por máquinas conectadas. Cada peça dos equipamentos tem suas restrições únicas. Por exemplo, locomotivas que transportam produtos através de áreas desérticas têm problemas de conectividade. Eles viajam para dentro e fora da cobertura da rede e, embora seja possível entregar dados de forma intermitente e receber informações da nuvem, é muito caro, impraticável e ineficaz.

Em alguns casos, a quantidade de dados gerados é tão grande que não há outra opção a não ser executar algum nível de computação no local da máquina. Uma plataforma de petróleo offshore, por exemplo, gera 1-2 terabytes de dados diariamente. Não faria sentido enviar imediatamente todos esses dados brutos para a nuvem sem pelo menos analisá-los no local para obter primeiro um valor potencial.

Quais são as aplicações práticas de Machine Learning na indústria?

O impacto da incorporação de novas tecnologias na indústria é enorme. Em oito setores industriais, o valor em jogo é superior a US$ 17 trilhões.

Quando o Machine Learning (ML) é aplicado aos dados industriais, ele abre novas portas para as empresas melhorarem suas operações e economizarem tempo e dinheiro. Eles podem prever e prevenir falhas de equipamentos antes que elas ocorram, melhorar a disponibilidade e a confiabilidade de seus ativos críticos e otimizar seus programas de manutenção com custo reduzido. Essa abordagem abrangente é conhecida como Gerenciamento de Desempenho de Ativos (APM).

Com o APM, as indústrias podem tomar decisões críticas sobre seus ativos com base em modos de falhas conhecidos e monitorar máquinas em tempo real, para determinar quais requerem manutenção com base em padrões históricos e condições, e tomar decisões críticas sobre os seus ativos, com base em informações preditivas.